数据去重 (Data Deduplication)

摘要:数据去重(Data Deduplication)是一种数据优化技术,通过识别并消除数据集中重复的数据副本,仅保留唯一的一份数据及其引用,从而减少存储空间占用、降低数据传输量并提高数据管理效率。 免费下载软件

后羿采集器,基于人工智能技术,无需编程,可视化操作,免费导出采集结果,只需输入网址就能自动识别采集内容的数据采集工具。

简介

数据去重(Data Deduplication)是一种数据优化技术,通过识别并消除数据集中重复的数据副本,仅保留唯一的一份数据及其引用,从而减少存储空间占用、降低数据传输量并提高数据管理效率。

适用场景

适用于大规模数据存储系统(如企业数据中心、云存储服务)、数据备份与归档场景(减少备份存储空间)、网络数据传输(如文件共享、邮件系统,降低传输带宽消耗)等数据重复率较高的场景。

优点:数据去重可大幅节省存储空间、提升数据传输效率并简化数据管理流程。

缺点:数据去重会增加系统计算开销、可能影响数据恢复且技术实现复杂度较高。

图例

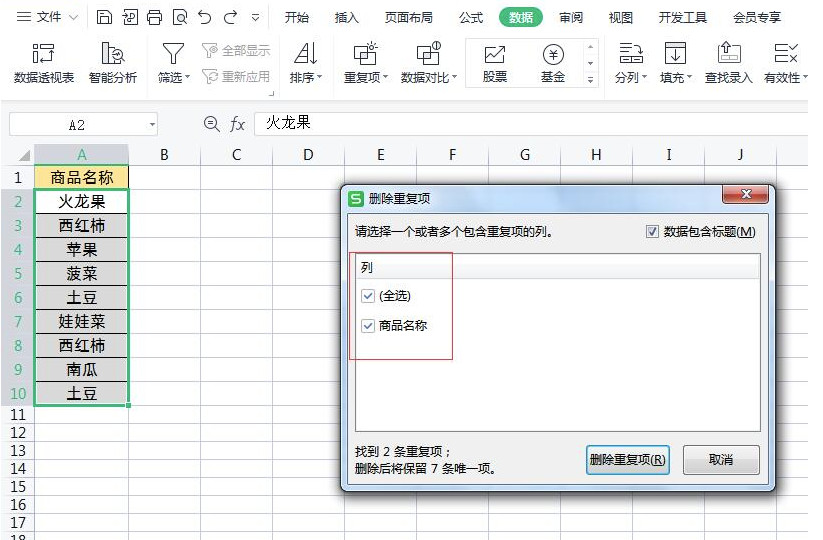

1. Excel数据去重。

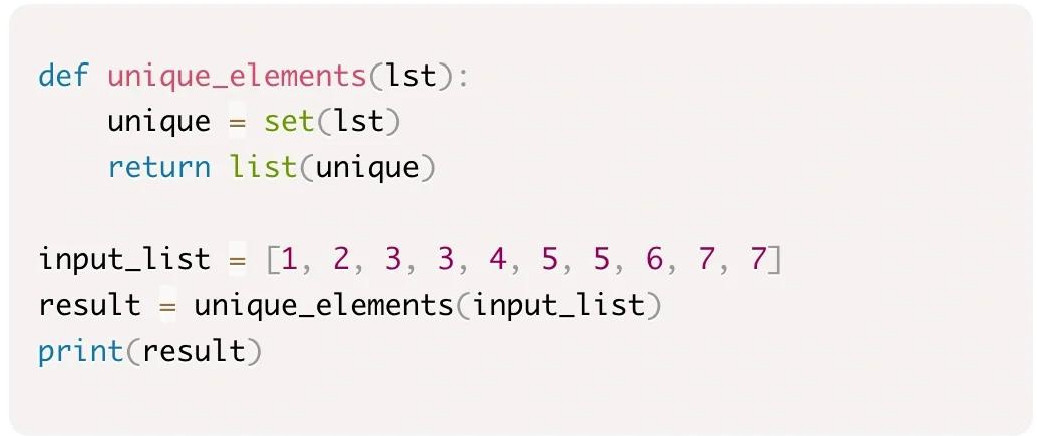

2. Python列表去重代码示例。

相关名词

参考资料

https://blog.csdn.net/universsky2015/article/details/138317758

https://www.cnblogs.com/luxiaoxun/p/14392375.html

https://blog.csdn.net/2301_79425796/article/details/141170282